私たちの脳は視覚情報を効率的に処理し、

必要なことだけを素早く判断します。

これに対して従来の

デジタルカメラやコンピューターでは、

映像をコマ送り(フレームごと)に取得し、

大量のデータを逐次処理していました。

データ量が膨大になるほど処理に

時間と電力を要し、

リアルタイムに判断することが難しくなります。

この問題を解決するために登場したのが

ニューロモルフィック・ビジョン

と呼ばれる技術です。

ニューロモルフィック(神経模倣)とは

脳神経の働きを模倣するという意味で、

人間の脳のような

アナログ信号処理を用いることで、

従来のデジタル方式よりもはるかに

省エネルギーで高度な視覚情報処理を

実現しようとする試みです。

実際、

研究グループリーダーのスミート・ワリア教授は

「ニューロモルフィックな視覚システムは

私たちの脳に近いアナログ処理を行うため、

現在のデジタル技術よりも複雑な

視覚タスクに必要なエネルギーを

大幅に削減できます」と指摘しています。

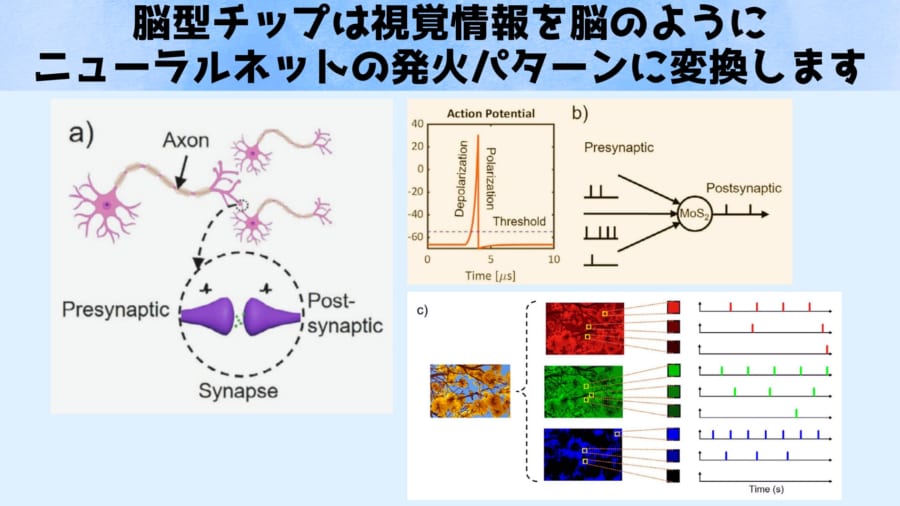

脳を模倣したコンピューティングの

核となるのが

スパイキング・ニューラルネットワーク

(SNN)と呼ばれる仕組みです。

これは、

生物のニューロン(神経細胞)が

電気パルス(スパイク)を発する

挙動を再現したもので、

信号が一定量蓄積されて

閾値に達すると“発火”し、

その後ニューロンがリセットされる

漏れ積分発火(LIF)モデルが

基本となっています。

SNNは不要な情報を抑えて必要な時だけ

スパイクを出力するため、

省電力かつ生物に近い情報処理が可能です。

しかし、

実際にこのようなニューロンの動きを

デバイス上で再現し、

カメラのような視覚センサーと

統合することは大きな課題でした。

研究チームはこの課題に挑み、

モリブデンジスルフィド(MoS₂)と呼ばれる

原子レベルに薄い半導体材料を用いて、

光で動作する人工ニューロンを

作り出すことを目指しました。

MoS₂などの二次元材料は

厚さ数原子のシート状物質で、

電子的・光学的性質を電圧で細かく制御でき、

省電力で柔軟なデバイス設計が

可能になることから注目されています。

今回の研究では、

この超薄型MoS₂に意図的に微小な欠陥

(原子レベルの不完全構造)を導入し、

光に対してニューロンのような

応答を引き出せるかを探りました。

研究チームが開発したのは、

モノレイヤー(一原子層)厚のMoS₂を使った

小さな光センサー内蔵トランジスタです。

このデバイスに光が当たると、

材料中の欠陥サイトが電子を捕獲・放出し、

まるでニューロンが電気信号を溜め込み

発射するような振る舞いを示します。

具体的には、

光刺激によって電流が徐々に増大し

(積分に相当)、

閾値に達すると急激にスパイク信号を出力し、

ゲート電圧を加えることで電流をリセットして

次の刺激に備えるという、

一連のLIFニューロン的な動作が確認されました。

筆頭著者のティハ・アウン博士課程研究者は

「私たちは原子レベルで薄い二硫化モリブデンが、

スパイキングニューラルネットワークの

基本要素であるリーキー積分発火

(LIF)ニューロンの挙動を正確に

再現できることを実証しました」と

説明しています。

つまり、

原子レベルのチップにおいても

脳の神経細胞のように電気を

少しずつためては

一定量でパッと放電する動きを、

そっくりそのまま再現

できることを確かめたのです。

このデバイスは光刺激による「膜電位」の

蓄積とスパイク出力を一体化して行えるため、

従来は別々の素子で担っていた

「センシング(検出)」「情報処理」

「メモリ保持」を融合できた点が画期的です。

さらに研究チームは、

このMoS₂チップを実際の

スパイキングニューラルネットワークに組み込み、

CIFAR10(静的画像)と

DVS128(動的ビジョン)の

データセットで最大約75~80%の

分類精度を達成可能であることも示しました。

実験ではまず、

目の前で手を振るというシンプルな

動作を対象にデバイスの反応を

テストしたところ、

通常のカメラが行うようにフレームごとの

撮影を行わずとも、

手の動きによる視界の変化を

即座に捉えることができました。

これはエッジ検出と呼ばれる手法で、

シーン全体ではなく変化の部分だけを検知できるため、

処理すべきデータ量と消費エネルギーを

大幅に削減できます。

実際、手の振れによるわずかな明暗の

変化を検知すると、

その瞬間にスパイク信号を発して

「手が動いた」というイベントを

自動的に記録しました。

人間が目で動きを捉えて脳に伝え

記憶するのと同様に、

このチップ自体が見る・処理する・覚えるを

完結させているのです。

ワリア教授は「この試作デバイスは、

人間の目が光を捉える能力と

脳が視覚情報を処理する能力を

部分的に再現しており、

大量のデータや大きなエネルギーを

必要とせずに環境の変化を瞬時に

察知できます」と強調しています。

さらにゲート電圧を用いたリセット機能により、

一度記録した後はすぐに次の変化を

捉えられる高速応答が可能です。

このように、

本研究のMoS₂チップは

センサー・プロセッサ・メモリを統合した

人工視覚ニューロンとして機能し、

SNNの基礎技術としても

応用できる可能性を示しました。

今回開発されたニューロモルフィック視覚デバイスは、

将来的に自律走行車やロボットの

「目」と「脳」を一つにまとめる技術として

大きな可能性を秘めています。

研究チームによれば、

この技術を応用することで、

自動運転車やロボットが予測困難な環境下でも、

危険の兆候をほぼ瞬時に察知し、

従来より格段に速い反応が

可能になるといいます。

ワリア教授は「こうした応用分野で

ニューロモルフィック・ビジョン技術が実現すれば、

大量のデータを処理せずともシーンの

変化をほぼ即座に検出し、

飛躍的に迅速な対応ができるように

なります」と述べています。

ワリア教授は続けて

「それは人命を救うことにも

つながり得るでしょう」と強調しています。

共同研究者のアクラム・アル=ホウラニ

(Akram Al-Hourani)教授は

「人間と密接に関わる製造現場や

家庭内でロボットが働く際にも、

この技術によって人間の動きを即座に認識・

反応できれば、遅延のない自然な

インタラクションが可能になるでしょう」と

期待を語っています。

このように、

本技術は安全性が要求される

自律システムや人と協調するロボットにとって

ゲームチェンジャーとなり得るでしょう。

もっとも、

現在のチップは概念実証段階の

単一ピクセルデバイスであり、

実用化に向けては課題も残ります。

ワリア教授も「我々のシステムは

脳の神経処理の一部を模倣したに過ぎず、

現時点ではまだ簡易化されたモデルです」と

慎重に述べています。

しかし研究チームはすでに、

この単一ピクセルのチップを格子状に

多数並べたピクセルアレイへ拡張する

研究に着手しており、

オーストラリア研究評議会からの

助成を受けて開発を進めています。

今後はデバイスの低消費電力化を

一層追求しながら、

より複雑な実世界の視覚タスクに

対応できるよう最適化を図っていく計画です。

さらに研究チームは、

今回用いたMoS₂以外にも材料の

可能性を模索しており、

将来は赤外線領域で動作するデバイスや

有毒ガス・病原体の

リアルタイム検知といった応用も

検討しています。

ワリア教授は「私たちの技術は従来の

コンピューティングを置き換えるのではなく、

補完するものだと考えています。

従来型のシステムにも得意な

処理は多くありますが、

私たちのニューロモルフィック技術は

エネルギー効率やリアルタイム性が決定的に

重要な視覚処理の場面で

優位性を発揮できます」と述べています。

従来型のシステムが

自動運転の5感的なものを担うとしたら、

脳型チップはそれにプラスアルファとなる

第6の処理システムとなれるわけです。

もしデータを学習することで進化するAIと

人間の脳のように疑似的な神経回路を持つ

脳型チップを組合わせることができれば、

より高度な機械知性を想像できるかもしれません。

<参考:>